Hace unos años que Cartoon Brew nos trajo un excelente artículo del render en tiempo real. En él se toca el tema de la convergencia entre las industrias del entretenimiento digital y el cómo ellas son afectadas por los nuevos avances tecnológicos.

En los últimos años ha sido constante el acercamiento entre las industrias de los videojuegos, los efectos visuales (VFX) y la animación. Todas ellas comparten las mismas herramientas para desarrollar los assets digitales y animarlas pero ya la calidad visual de los videojuegos está alcanzando el nivel de fotorrealismo que había sido exclusivo de los VFX. Esto en sí mismo es impresionante, los VFX son imágenes pre-rendereadas y los videojuegos se basan es el cálculo y procesamiento instantáneo para generar un ambiente virtual.

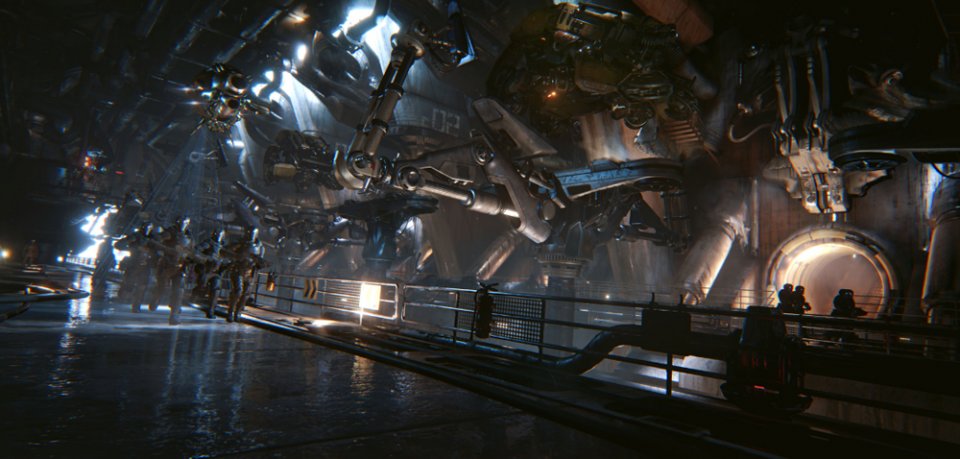

Fotorrealismo en Unreal

Tangencialmente esto nos lleva a cómo la tecnología de los videojuegos, en éste caso el render en tiempo real, empieza a permear al VFX y a la animación.

Son varias la compañías que han estado empujando el desarrollo de las tecnologías del tiempo real, en este artículo se habla de Epic Games, compañía que desarrolla el Unreal Engine. Epic Games ha estado experimentando en áreas que habían sido exclusivas de los VFX y la animación: producción virtual, humanos digitales, series animadas e incluso comerciales de publicidad.

El Render en tiempo real

Este lo podríamos definir como: La representación y resolución “instantánea” de escenarios o situaciones digitales que permiten al usuario el interactuar o moverse en ellas.

Debido a que imágenes CG complejas toman mucho tiempo en representarse -léase: renderizarse- la calidad visual del render en tiempo real nunca ha sido igual a la de las imágenes pre-rendereadas que logran los motores de render RenderMan, Arnold o V-Ray.

Gravity y Arnold Renderer

Sin embargo, diferentes efectos de óptica y física así como algoritmos de raytracing han estado siendo implementadas en los motores de videojuegos. Unreal 4 ya permite hacer composición de elementos CG con live-action. Lo que significa que a pesar de que visualmente no estén totalmente al nivel de los motores de render tradicionales ya bien pueden ser considerados dentro de un pipeline de producción.

Ejemplo notable de estas tecnologías “híbridas” es el cortometraje de Chevrolet “The Human Race”. Un carro de utilería fue filmado como base para ser reemplazado digitalmente por variedades distintas de carros en CG. Esto fue planeado con la intención que el usuario pudiera cambiar a voluntad y en tiempo real las características del carro tales como marca, color, etc.

[The Human Race es] … El primer cortometraje live-action configurable en el mundo

En otro ejemplo, el videojuego de Hellblade: Senua´s Sacrifice producido por Ninja Theory demuestra el como secuencias grabadas en live action fueron capturadas, renderizadas y editadas en tiempo real.

La secuencia del droid K-2SO en tiempo real.

El trailer del videojuego Fortnite fue renderado exclusivamente con Unreal 4. Esto quiere decir que el flujo de trabajo no se basó en renders nocturnos y permitió un mayor número de iteraciones durante la producción. Digital Dimension está trabajando en Zafari, una serie animada hecha entre Unreal y métodos tradicionales de animación.

¿Qué se podría esperar?

Entre más se adopte el render en tiempo real para efectos visuales y animación los artistas contarán con un mayor número de herramientas que permitirán ver resultados más rápidamente y con una menor dependencia de las granjas de render. La flexibilidad de tener mundos virtuales completos en los que uno se puede mover a voluntad generará una libertad creativa que antes había estado restringida.

“Hoy ya se usan las mismas herramientas tanto para videojuegos como para cine – dice Kim Libreri, supervisor de efectos visuales nominado al Oscar que hoy es CTO de Epic Games – se habla prácticamente el mismo lenguaje. La única diferencia es ese milisegundo”.

Y quien sabe, en un futuro el render en tiempo real bien podría suplir completamente las producciones pre-rendereadas.